php 网站 开源支持用户词典扩展定义针对全文检索优化的查询(作者吐血推荐)php开源网站系统

2022-11-01

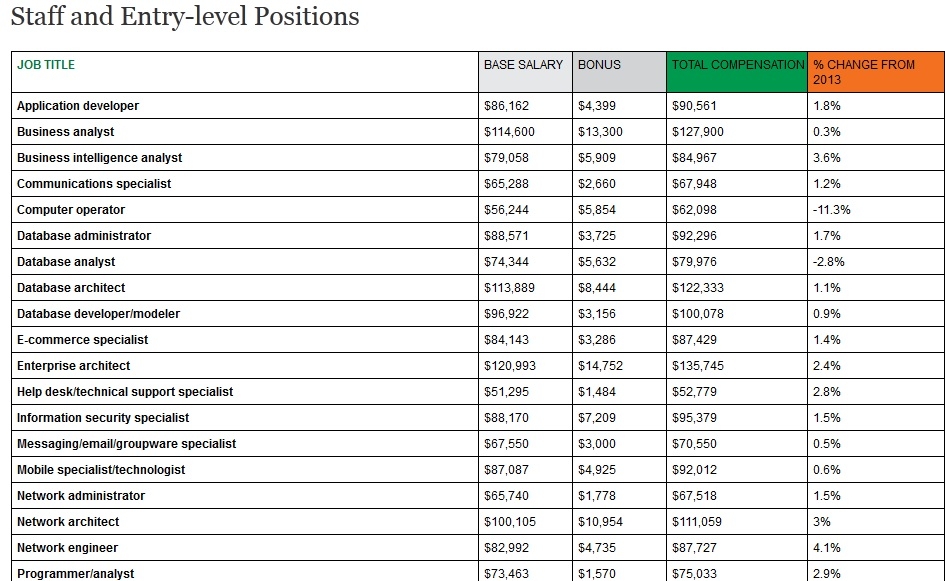

1、

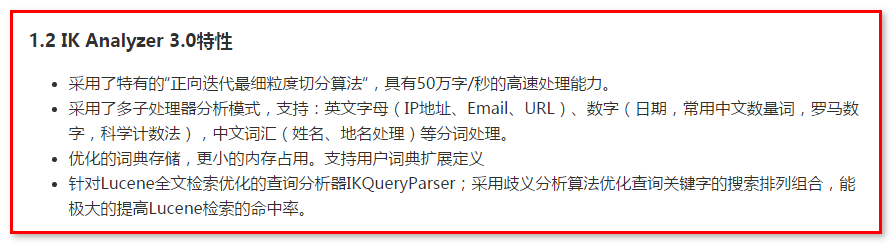

是一个基于java语言开发的开源轻量级中文分词工具包。自 2006 年 12 月发布 1.0 版以来,已经发布了三个主要版本。最初,它是一个基于开源项目的中文分词组件,结合了字典分词和语法分析算法。新版本 .0 是作为 Java 的通用分词组件开发的,它独立于项目,并提供了对的默认优化实现。

.0 特点:

它采用独特的“前向迭代细粒度切分算法”,具有每秒60万字的高速处理能力。

采用多子处理器分析模式,支持:英文字母(IP地址、URL)、数字(日期、常用中文量词、罗马数字、科学记数法)、中文词汇(人名、地名处理)等分词加工。

优化的字典存储,更小的内存占用。支持用户词典扩展定义

针对全文检索优化的查询分析器(作者推荐);使用歧义分析算法优化查询关键词的搜索排列和组合,可以大大提高检索的命中率。

许可协议:LGPL

开发语言:Java

操作系统:跨平台

录制时间:2008年12月3日(国产软件)

下载:或

2.盘古分词

盘古分词是基于.net的中英文分词组件,提供(.net版)和接口。

高效:Core Duo 1.8 GHz 单线程分词速度 390K 字符/秒

准确:盘古分词采用字典和统计相结合的分词算法,分词准确率高。

功能:盘古分词提供中文姓名识别、简繁混合分词、多分词、英文生根、强制一元分词、词频优先分词、停用词过滤、英文专有名称提取等一系列功能。

许可协议:

开发语言:C#.NET

操作系统:

征集时间:2010年12月29日

下载:或:

3.

中文分词库是Java开发的中文分词组件,可以集成到互联网和企业内网的应用程序中。填补了国内中文分词开源组件的空白,并致力于此网站开发,希望成为互联网网站中文分词开源组件的首选。中文分词追求分词效率高,用户体验好。

的中文分词具有极高的效率和高扩展性。引入隐喻,完全面向对象的设计,先进的概念。

效率高:在PIII 1G内存的个人电脑上,1秒就能准确切分100万个汉字。

文章基于无限数量的词典文件进行有效分割,实现词汇的分类和定义。

能够合理地解析未知词汇

许可协议:

开发语言:Java

操作系统:跨平台

录制时间:2008年9月7日(国产软件)

下载:或

4.

中科院最新免费开源代码,包含中文分词算法,大家可以一起学习研究,对搜索引擎的中文分词很有用。

许可协议:未知

开发语言:C/C++

操作系统:

录制时间:2010年10月20日(国产软件)

下载:

5.

是专为全文搜索引擎设计的中文分词软件包。其根据 GPL 协议发布的中文分词方法采用 Chih-Hao Tsai 算法。

您可以在 Chih-Hao Tsai 的页面上找到算法的原文。

采用C++开发,支持平台和平台,分割速度约300K/s(PM-1.2G)。目前版本(0.7.1)还没有对速度进行仔细的优化,分割速度应该还有进一步提升的空间。.

许可协议:未知

开发语言:C/C++

操作系统:跨平台

录制时间:2009年5月31日(国产软件)

下载:0.7.3

6.

是一个开源的PHP中文分词扩展,目前只支持/Unix系统,项目现已更名,本项目不再维护。

首先使用“3.0共享中文分词算法”的API进行初始分词处理php 网站 开源,然后使用自己编写的“反向最大匹配算法”进行分词和分词处理,并添加标点过滤功能得到分词结果。

( , ) 是中国科学院计算技术研究所在多年研究工作的基础上,基于多层隐马模型开发的中文词法分析系统。其主要功能包括中文分词;词性标注;命名实体识别;生词识别;还支持用户词典。经过五年的精心建设,内核升级了6次php 网站 开源,现在已经升级到.0,分词准确率为98.45%seo优化,各种词典数据压缩小于3M。该活动在国内973专家组组织的评审中获得第一名,在首个国际华人加工研究组织组织的评审中获得多项第一名。

许可协议:BSD

开发语言:PHP

操作系统:跨平台

录制时间:2009年3月19日(国产软件)

下载: