轻量php框架模型更新了!大规模视觉表征学习的新时代来了 php框架 教程

2023-01-23

模型已更新!

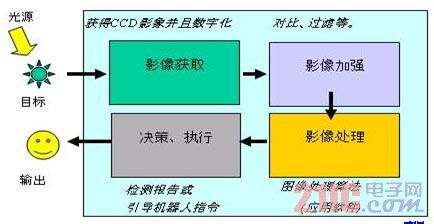

经过数十年的基础研究,视觉识别领域迎来了大规模视觉表示学习的新时代。 预训练的大规模视觉模型已成为特征学习和视觉应用的基本工具。 视觉表示学习系统的性能在很大程度上受三个主要因素的影响:模型的神经网络架构、用于训练网络的方法和训练数据。 每个因素的改进都有助于模型整体性能的提高。

神经网络架构设计的创新一直在表示学习领域发挥着重要作用。 腾云网络架构()对计算机视觉研究产生了重大影响,使得在各种视觉识别任务中使用通用特征学习方法成为可能,而无需依赖人工实现的特征工程。 近年来,最初为自然语言处理而开发的架构因其对不同规模的模型和数据集的适用性而开始广泛应用于其他深度学习领域。

架构的出现使传统架构现代化,表明纯卷积模型也可以适应模型和数据集的规模变化。 然而,探索神经网络架构设计空间的最常用方法仍然是监督学习的性能基准测试。

另一种思路是将视觉表示学习的重点从标记监督学习转移到自我监督预训练。 自监督算法将掩码语言建模引入视觉领域,并迅速成为视觉表示学习的流行方法。 然而,自我监督学习通常使用专为监督学习设计的架构,并假设该架构是固定的。 例如,掩码自动编码器 (MAE) 使用视觉架构。

一种方法是将这些架构与自我监督学习框架相结合,但面临一些特定问题。 例如,当与 MAE 结合时会出现一个问题:MAE 具有针对序列处理能力优化的特定编码器-解码器设计,这使得计算密集型编码器专注于那些可见的,从而降低预训练成本。 但这种设计可能与使用密集滑动窗口的标准设计不兼容。 此外,如果不考虑架构与训练目标之间的关系seo优化,是否可以实现最佳性能尚不清楚。 事实上,已经表明使用基于掩码的自监督学习进行训练是困难的,并且实验证据表明 ,并且可能在特征学习中发散,影响最终表示的质量。

为此,来自 Meta 和纽约大学的研究人员(包括一位作者刘庄和一位作者谢赛宁)提出在同一框架下共同设计网络架构和掩码自动编码器。 这样做的目的是让基于mask的自监督学习能够拟合模型并得到媲美的结果。

论文地址:

在设计掩码自动编码器时,该研究将掩码输入视为稀疏集,并使用稀疏卷积来处理可见部分。 这个想法的灵感来自于在处理大规模 3D 点云时使用稀疏卷积。 具体来说,该研究提出实现稀疏卷积,然后在微调时,可以将权重转换回标准的密集网络层,无需特殊处理。 为了进一步提高预训练效率,本研究将解码器替换为单个解码器网站制作,使整个设计完全卷积。 研究人员观察到,加入这些变化后:学习到的特征是有用的,提高了基线结果,但微调后的性能仍然不如基础模型。

然后,该研究分析了不同训练配置的特征空间。 当直接对屏蔽输入进行训练时,我们发现 MLP 层中存在潜在的特征崩溃 ( ) 问题。 为了解决这个问题,本研究提出添加一个全局响应归一化层 ( ) 来增强通道之间的特征竞争。 当使用屏蔽自动编码器对模型进行预训练时,这种改进最为有效,这表明在监督学习中重用固定架构设计可能不是最佳选择。

基于以上改进,本研究提出了 V2,它在与掩码自动编码器结合时表现出更好的性能。 同时,研究人员发现,V2 在各种下游任务上比 pure 有显着的性能提升轻量php框架,包括 上的分类任务、COCO 上的目标检测和 上的语义分割。

方法介绍

全卷积屏蔽自动编码器

本研究中提出的方法在概念上很简单,并且以完全卷积的方式运行。 学习信号是通过以高掩蔽率随机掩蔽原始视觉输入,然后让模型从其余部分预测缺失部分来生成的。 整体框架如下图所示。

该框架由一个基于稀疏卷积的编码器和一个轻量级解码器组成,其中自动编码器的结构是不对称的。 编码器仅使用可见像素,而解码器使用编码像素和掩码来重建图像。 同时,loss只在区域计算。

全局响应标准化

大脑中有许多促进神经元多样性的机制。 例如,侧抑制可以帮助增强激活神经元的反应,增加单个神经元对刺激的对比度和选择性,同时还增加神经元群体之间反应的多样性。 在深度学习中,这种形式的横向抑制可以通过响应归一化 ( ) 来实现。 该研究引入了一个新的响应归一化层轻量php框架,称为全局响应归一化 (GRN),旨在提高跨通道的对比度和选择性。 GRN 单元包括三个步骤:1)全局特征聚合,2)特征归一化,以及 3)特征校准。 如下图所示,可以将GRN层合并到原始块中。

研究人员根据实验发现,在应用GRN时,不需要,可以删除。 使用这种新的块设计,该研究创建了各种具有不同效率和容量的模型,他们将其称为 V2 模型系列,从轻量级 (Atto) 到计算密集型 (Huge)。

为了评估 GRN 的效果,该研究使用该框架来预训练 V2。 从下图 3 的可视化和图 4 的余弦距离分析可以看出,V2 有效地缓解了特征崩溃问题。 余弦距离值一直很高,说明可以通过网络层传输保持特征多样性。 这类似于使用 MAE 预训练的 ViT 模型。 这表明在相似的掩码图像预训练框架下,V2 的学习行为与 ViT 相似。

该研究进一步评估了微调性能,结果如下表所示。

当配备 GRN 时,预训练模型可以显着优于使用 300 训练的监督模型。GRN 通过增强特征多样性来提高表示质量,这对于基于掩码的预训练至关重要,而 V1 模型中不存在。 值得注意的是,这种改进是在没有增加额外参数开销的情况下实现的,也没有增加 .

最后,该研究还检验了 GRN 在预训练和微调中的重要性。 如下表2(f)所示,无论是从fine-中移除GRN还是在fine-过程中加入新初始化的GRN,性能都明显下降,这说明GRN在预训练和微调中的重要性。